摘要:robots.txt的纯文本文件,这个文件用于指定spider在您网站上的抓取范围。升级后robots将优化对网站视频URL收录抓取情况。

robots 是网站与蜘蛛沟通的重要渠道,网站使用 robots 文件来声明网站中不希望被搜索引擎索引的部分,或者指定搜索引擎只索引特定部分。

搜索引擎利用蜘蛛程序自动访问互联网上的网页并获取网页信息。当蜘蛛访问网站时,它们会首先检查该网站的根域下是否有一个名为 robots.txt 的纯文本文件。此文件用于指定蜘蛛在您网站上的爬行范围。您可以在您的网站中创建一个 robots.txt,并在文件中声明您不希望搜索引擎索引的网站部分或指定搜索引擎只索引特定部分。

请注意,只有当您的网站包含您不希望搜索引擎索引的内容时,您才需要使用 robots.txt 文件。如果您希望搜索引擎索引您网站上的所有内容,请不要创建 robots.txt 文件。

robots.txt 文件位于哪里?

robots.txt文件应该放在网站的根目录下,比如当蜘蛛访问一个网站时,它会先检查网站上是否有一个叫***.com/robots.txt的文件,如果蜘蛛找到这个文件,它会根据这个文件的内容来确定自己的访问权限范围。

robots.txt 文件的格式

robots文件通常放在根目录下,包含一条或多条记录,每条记录之间以空行分隔(以CR、CR/NL或NL为结束符),每条记录的格式如下:

“:”

可以使用#来注释此文件,具体用法和UNIX中的约定相同,此文件中的记录通常以一行或多行User-agent开头,后面跟着几行Disallow和Allow,具体如下:

User-agent:此项的值用于描述搜索引擎机器人的名称。在“robots.txt”文件中,如果存在多条User-agent记录,则意味着有多个机器人会受到“robots.txt”的限制。对于此文件,必须至少有一条User-agent记录。如果此项的值设置为*,则对任何机器人都有效。在“robots.txt”文件中,只能有一条记录,例如“User-agent:*”。如果在“robots.txt”文件中添加了“User-agent:SomeBot”和多行Disallow和Allow行,那么名为“SomeBot”的机器人将只受到“User-agent:SomeBot”后面的Disallow和Allow行的限制。

Disallow:此项的值用于描述一组你不希望被访问的URL,该值可以是完整路径robots 禁止百度收录,也可以是路径的非空前缀。以Disallow项的值开头的URL将不会被机器人访问。例如“Disallow:/help”禁止机器人访问/help.html、/helpabc.html、/help/index.html,而“Disallow:/help/”允许机器人访问/help.html和/helpabc.html,但不允许/help/index.html。“Disallow:”表示允许机器人访问网站的所有URL。“/robots.txt”文件中必须至少有一条Disallow记录robots 禁止百度收录,如果“/robots.txt”不存在或为空文件,则该网站对所有搜索引擎机器人开放。

Allow:此项的值用于描述一组希望访问的URL。与Disallow项类似,此项的值可以是完整路径,也可以是路径的前缀。以Allow项的值开头的URL允许机器人访问。例如,“Allow:/hibaidu”允许机器人访问/hibaidu.htm、/hibaiducom.html、/hibaidu/com.html。由于网站的所有URL默认都是Allow的,所以Allow通常与Disallow配合使用,允许访问某些网页,同时禁止访问其他所有URL。

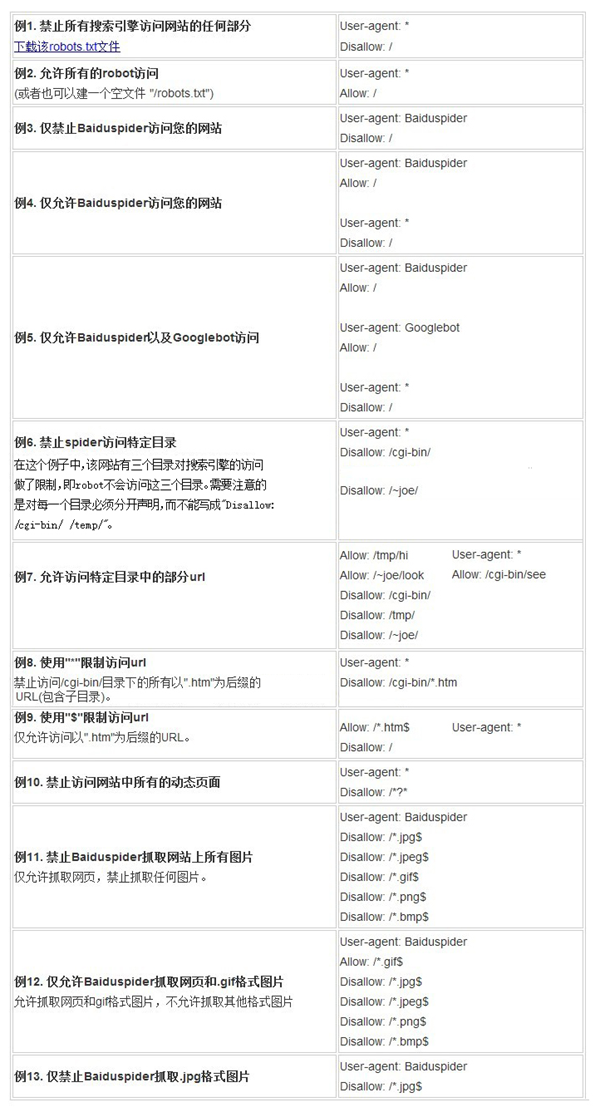

使用“*”和“$”:Baiduspider支持使用通配符“*”和“$”来模糊匹配URL。

“*”匹配0个或多个字符

“$”匹配行尾字符。

最后需要注意的是,百度会严格遵守robots的相关协议,请注意你不希望被抓取或收录的目录的大小写,百度会对robots中写的文件和你不希望被抓取或收录的目录进行精确匹配,否则robots协议不会生效。

robots.txt 文件使用示例

网站误封Robots如何处理

robots文件是搜索生态系统中非常重要的一个部分,也是非常细致的一个部分,很多站长在网站运营过程中往往会忽略robots文件的存在,而错误地覆盖或者彻底禁止robots,造成不必要的损失!

那么如果机器人被误封了该怎么办呢?今天我们邀请了厦门网站运营负责人来和大家分享一下如果机器人被误封了该怎么办?

【案件背景】

网站开发2.0版本,技术选择了线上开发,为了不让搜索引擎抓取开发版,要求技术人员设置Robots拦截。2.0版本开发周期1个月,一个月后网站版本迭代,直接覆盖1.0版本,包括Robots拦截文件。两天后发现流量大幅下降,查看收录项发现800万收录项降为0,大量关键词下线。

【处理方法】

1.将Robots禁止改为允许,然后去百度搜索资源后台检查并更新Robots。

2、在百度搜索资源的后台抓取检测中,显示抓取失败,没关系,多点击几次抓取,即可触发蜘蛛抓取网站。

3.申请增加百度搜索资源后台的抓取频率。

4、百度反馈中心:反馈是由于操作失误导致的这种情况。

5.在百度搜索资源后台链接提交区,设置数据API推送(实时)。

6.每天更新站点地图并手动重新提交给百度一次。

完成上述处理之后,接下来就是等待了,还好2天之后数据开始慢慢恢复,第3天基本就恢复正常了!

【概括】

这次事故绝对是我运营生涯的一个失败,经过总结反思,希望大家能够避免类似的问题。

1、产品开发一定避免在线开发,不能为了省事而避免搭建开发环境。

2、产品迭代一定要有过程记录,开发时做了哪些设置、处理,哪些不需要发布,哪些必须发布,而且这个要非常清楚。

3.时刻关注百度搜索资源后台,关注相关数据的变化,及时从数据变化中发现问题

百度搜索机器人协议全面升级

9月11日,百度搜索机器人进行了升级,升级后,机器人会优化对网站视频网址的抓取。只有当您的网站包含不希望被视频搜索引擎收录的内容时,才需要使用robots.txt文件。如果您希望搜索引擎收录您网站上的所有内容,则不要创建robots.txt文件。

如果您的网站没有设置robots协议,百度搜索会收录视频页面的URL、页面内的视频文件、视频周边的文字等信息,对收录的短视频资源的搜索会以视频极速体验页面的形式呈现给用户,另外综艺、电影等长视频,搜索引擎只会收录页面URL。

网站搜索引擎优化